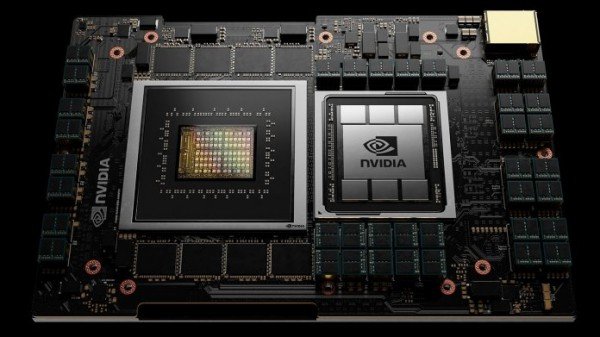

Grace: Nvidias erster ARM-Prozessor für Supercomputer

Grace nutzt ARM-Neoverse-Rechenkerne sowie schnelle NVLink-Interconnects und LPDDR5X-Speicher z. Hd. hohe Transferraten.

Nvidia Grace (Bild: Nvidia)

Von

- Martin Fischer

Nvidia hat den ersten eigenen ARM-Prozessor z. Hd. High Performance Computing und Künstliche Intelligenz vorgestellt. Mit dem Namen „Grace“ verweist Nvidia laut Vorsitzender des Vorstands Jensen Huang aufwärts die US-amerikanische Computerpionierin Grace Hopper. In dieser Graphikprozessor-Gerüchteküche galt deren Nachname „Hopper“ zuletzt qua Kandidat z. Hd. die Bezeichnung des Chips. Nvidia übernimmt derzeit den CPU-Entwickler ARM.

Grace soll ab Anfang 2023 verfügbar sein und in Supercomputer-Systemen Verwendung finden – wie wie im Alps-Supercomputer des Swiss National Supercomputing Center. Huang zufolge soll in Alps nicht zuletzt die nächste Generation von Nvidia-Rechenbeschleunigern zum Einsatz kommen. Seit einiger Zeit ist Nvidias Rechenbeschleuniger-Programmierplattform CUDA nicht zuletzt aufwärts Servern mit ARM-Prozessoren nutzbar. Nvidia bereitet dies eigene HPC-SDK sowie die CUDA-/CUDA-X-Bibliotheken z. Hd. Grace vor.

Alps wird von Hewlett Packard Enterprise aufwärts Cray-EX-Basis gebaut und ersetzt den bisherigen Piz-Daint-Supercomputer.

Nvidia

Grace mit ARM Neoverse

Nvidia Grace setzt aufwärts ARM-Kerne aus dieser z. Hd. Server ausgelegten Familie Neoverse, die verbleibend 300 Punkte beim Benchmark SPECrate2017_int_base erzielen sollen. Neoverse-Kerne kommen wie nicht zuletzt im Zusammenhang Amazons Graviton2-Prozessoren und Altra-Max-Prozessoren von Ampere zum Einsatz sowie im künftigen EU-Prozessor Rhea.

Die Architektur von Grace soll z. Hd. insbesondere hohe Transferraten sorgen – selbige sind beim verteilten Rechnen verbleibend mehrere Instanzen von zentraler Bedeutung. Zugreifen können die Grace-Kerne aufwärts ECC-geschützten LPDDR5x-Speicher, dieser insbesondere hohe Transferraten von verbleibend 500 GByte/s glücken soll.

Mit anderen Grafikprozessoren kommuniziert Grace verbleibend schnelle, Cache-kohärente Interconnects – Nvidia zufolge sind verbleibend die vierte NVLink-Generation CPU-zu-(Nvidia-)Graphikprozessor-Transferraten von 900 GByte/s möglich; von CPU zu CPU noch 600 GByte/s.

Zum Entwickeln und ARM-Migrieren von HPC-Anwendungen bietet Nvidia ein HPC-Devkit samt zugehörigem SDK an.

(Bild: Nvidia)

CUDA-Code-Portierung

Mithilfe des Nvidia HPC SDK sollen Wissenschaftler und Entwickler ihre HPC- und KI-Software aufwärts Graphikprozessor-beschleunigte ARM-Systeme migrieren können. Um solche Migrationen schon zu starten, ehe Grace aufwärts den Markt kommt, kündigte Nvidia verbinden mit Amazon EC2-Instanzen in dieser AWS-Cloud mit Graviton2-CPU und Nvidia-GPUs an.

Nvidia bietet Entwicklern außerdem ein ARM HPC Developer Kit an, dies aus einer Ampere-Altra-CPU mit 80 ARM-Neoverse-Kernen (solange bis 3,3 GHz), zwei Nvidia A100-GPUs (624 FP16-TFlops) und zwei BlueField-2-DPUs besteht.

Nvidia

(mfi)

Quelle: www.heise.de